1 个回答

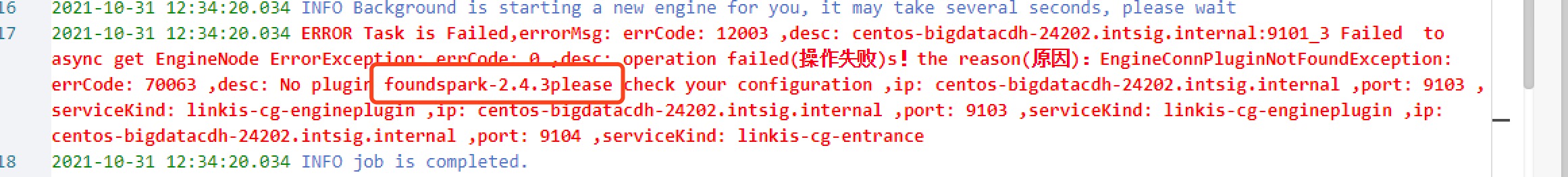

这是spark配置版本与实际使用版本不一致,解决办法:

可参考官网的文档:

在如下两个配置

linkis/conf/linkis.properties

dss/conf/dss-flow-execution-server.properties (特别是这个地方容易忽视)

中加入配置wds.linkis.spark.engine.version=2.4.8

可参考官网的文档:

https://linkis.apache.org/zh-CN/docs/latest/deployment/install-engineconn发布于:2年前 (2023-10-11) IP属地:四川省

我来回答

您需要 登录 后回答此问题!