前面几篇文章主要介绍的是基于大模型做应用的开发工具,例如:Langflow、Flowise、Dify、AutoGTP UI。这里我们再介绍一个非常重要的大模型工具-Ollama。

目前国内开源的大模型非常多,但是在应用上大家还是基于保守一点,比如字节提供了一个名称为《扣子》的应用,但是为什么大部分都是个人在使用,而企业不使用呢?最主要的原因就是数据保密及知识产权的问题(详见《大家为什么不用扣子》)。所以目前对于企业来说,在本地部署大模型应用更贴合企业的实际情况。

既然需要在本地部署大模型,那么这个Ollama工具就几乎是大家必须了解的工具。

Ollama介绍

Ollama 是一个开源的框架,旨在简化大型语言模型的部署和管理。它提供了一个轻量级的 HTTP 服务,允许用户通过 API 接口与模型进行交互。然而,由于其默认配置可能不够安全,尤其是在网络暴露和访问控制方面,Ollama 服务可能成为潜在的攻击目标。

注意: Ollama 默认开放 11434 端口,且无任何鉴权机制。如果不加以防护,Ollama 私有化部署的方式存在数据泄露、算力盗取、服务中断等安全风险,极易引发网络和数据安全事件。

Ollama的安装

前面我们介绍过ollama的安装步骤,详情可参考《Ollama安装》。本文暂不做过多介绍

Ollama官方支持部署的大模型

Ollama官方支持部署的大模型有以下几种:

| 模型名称 | 部署命令 | 备注 |

| deepseek-r1 | ollama run deepseek-r1:7b | 幻方量化开源大模型 |

| Qwen | ollama run qwen:7b | 阿里云开源大模型 |

| Yi | ollama run yi:34b | 零一万物开源大模型 |

| LLaMA 2 | ollama run llama2 | Meta开源大模型 |

| Mistral | ollama run mistral | Mistrak AI开源大模型 |

| Code Llama | ollama run codellama | Meta开源大模型 |

| Phi-2 | ollama run phi | 微软开源大模型 |

| Falcon | ollama run falcon | 阿联酋TII开源大模型 |

| Vicuna | ollama run vicuna | LMSYS社区基于LLaMA微调的大模型 |

| WizardCoder | ollama run wizardcoder | WizardLm开源大模型 |

| Orca2 | ollama run orca2 | 微软开源大模型 |

| Stable Beluga | ollama run stable-beluga | Stability AI开源大模型 |

| OpenChat | ollama run openchat | OpenChat开源大模型 |

| Neural Chat | ollama run neural-chat | Intel开源大模型 |

| Dolphin | Ollama run dolphin | Eric HartFord开源大模型 |

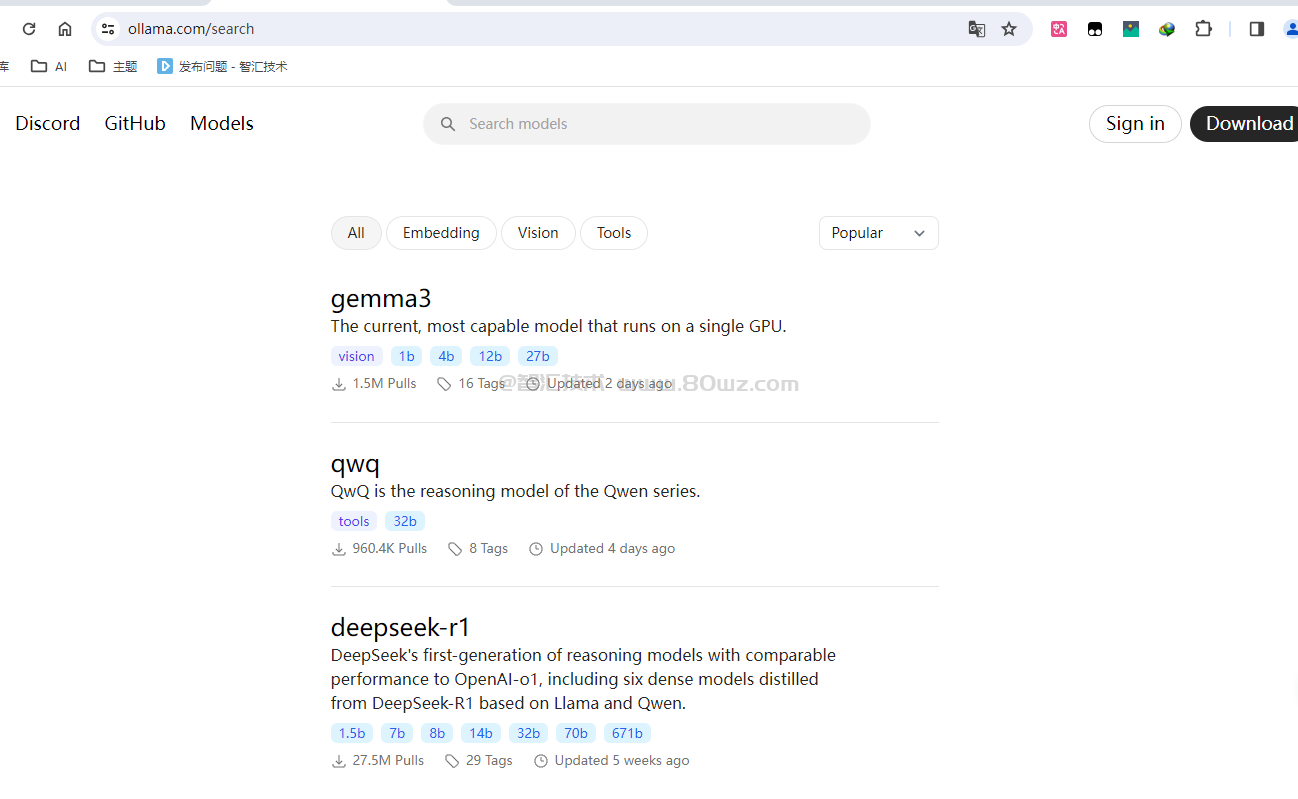

除了以上列举的还有非常多,大家可以在Ollama官网查询搜索到:

Ollama常用的命令

上面可以看出,ollama是使用命令部署模型的,但是除了run命令之外我们还需要熟悉一下其他的命令,例如:

| 常用命令 | 示例 | 说明 |

| ollama server | ollama server | 启动ollama server服务 |

| ollama create ${自定义模型名称} -f ${ModeFile文件路径} | ollama creare mymodel -f ./ModelFile | 使用模型文件创建一个模型 |

| ollama show ${模型名称} | ollama show deepseek-r1:14b | 查看模型的信息 |

| ollama run ${模型名称} | ollama run qwen2.5 | 运行模型 |

| ollama stop ${模型名称} | ollama stop qwen2.5 | 停止模型 |

| ollama pull ${模型名称} | ollama pull qwen2.5 | 从注册表拉取某个模型到本地仓库(类似拉取docker镜像) |

| ollama list ${模型名称} | ollama list | 查看本地仓库的模型(即拉取到本地仓库的所有模型) |

| ollama cp ${源模型名称} ${目的模型名称} | ollama cp qwen2.5 qwen2.6 | 复制模型 |

| ollama push username/${模型名称} | ollama push zhangsan/mymodel:latest | 推送模型 |

| ollama ps | ollama ps | 列出正在运行的模型 |

| ollama rm ${模型名称} | ollama rm qwen2.5 | 删除模型 |

以上就是本地部署ollama的时候常用的命令,可以很方便的为我们在本地部署大模型提供支持。

还没有评论,来说两句吧...