在前些年,对于业界来说,发生过一些重大的事故,例如:

1、2015 年 5 月 27 日,杭州市某地光纤被挖断,近 3 亿用户长达 5 小时无法访问支付宝 2、2021 年 7 月 13 日,B 站部分服务器机房发生故障,造成整站持续 3 个小时无法访问 3、2021 年 10 月 9 日,富途证券服务器机房发生电力闪断故障,造成用户 2 个小时无法登陆、交易 4、2022 年 12 月 18 日,阿里云香港可用区C发生大规模服务终端事件,造成用户15.5小时不能稳定使用产品 6、2023 年 12 月 3 日,腾讯视频app发生故障,造成用户大约3小时不能稳定使用 等等

以上算是今年发生的大规模故障的案例,当然除了一些人肉运维造成的不可挽回的错误之外,很多时候,对于服务器机房的损坏,光缆网络的终端等等都有很多的关系,为什么大厂出现各大类问题的时候,都会造成很大的影响。原因就是这些大厂的应用几乎都分布在我们生活的方方面面。所以,对于咱们做IT系统建设的团队来说,系统的高可用性要求就比较高,在做相关的系统设计的时候,就要超前的考虑系统的高可用的方方面面,防止出现各种问题。这是会对企业造成很大影响的事宜。

目前的原厂商系统(例如:阿里云,腾讯云,华为云等等云系统)他们的系统可用性号称都是能达到6个9的标准,也就是99.9999%。当系统达到了6个9的标准的时候,我们会发现系统发生故障到修复的时间,全年加起来不超过32秒。大家看这个系统的要求高不高?像如果是你来建设这样的系统的话,你会如何来保障系统的高可用呢?

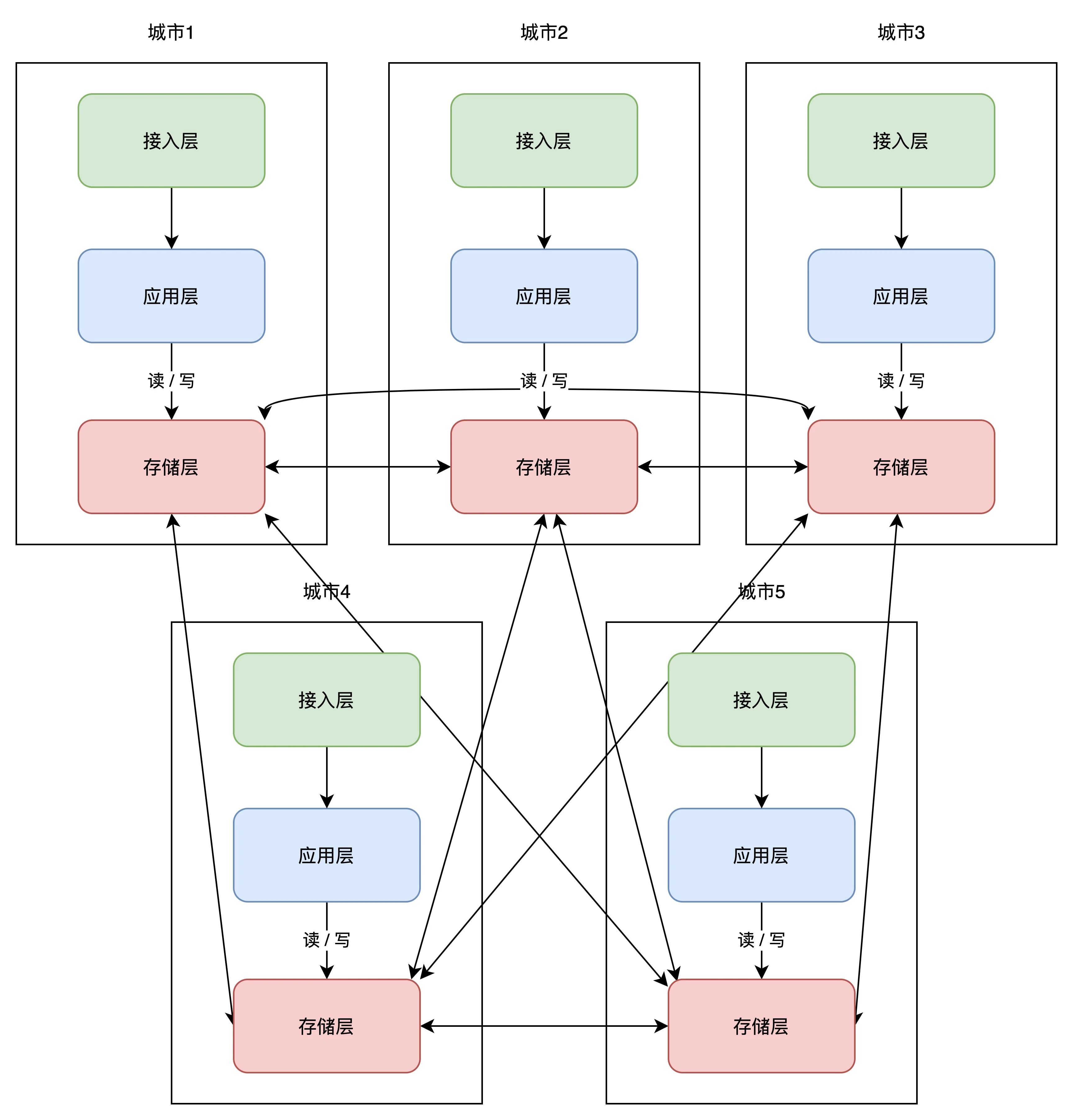

在日常的工作中,为了确保系统的高可用,我们除了从软件开发方面,运维实施方面考虑系统的稳定性之外,其实最大的层面还要考虑物理层面的系统稳定性,高可用。基于此,在业界中,我记得阿里巴巴在10年前就提出异地多活,两地三中心的概念。这就是从物理上来保障系统高可用的案例。

所以这里回答下题目? 为什么要有异地多活的架构?原因就是:

当前的系统已经是非常庞大的系统了,已经到了必须保证6个9级别的7*24小时不间断服务,不能因为外界物理的干扰,造成服务的中断

最后补充一下:

1、一般异地多活的的架构是系统已经庞大到了不能出现任何中断的情况了。 2、如果是小公司企业的话,一般我们在前期还是主要考虑日活,流量/业务增长即可。 3、实施异地多活的成本非常高,详情可参考后面的文章。 4、我本人到目前为止的职业生涯,也没有参与过实际的异地多活架构业务,但是根据和行业大佬进行沟通,我理清了相关的情况,所以才整理下这个系列。

还没有评论,来说两句吧...